DIK - Data, Information, Knowledge

La pagina di Piero Melli

L'acronimo DIK (vedi, per es. Wikipedia) si riferisce al modello concettuale piramidale con il quale vari studiosi hanno rappresentato le relazioni gerarchiche fra dati,informazione e conoscenza. Il processo che permette di passare dai dati elementari alle informazioni e quindi alla conoscenza comprende le metodologie di modellazione, organizzazione e rappresentazione dei dati, nonché le analisi e gli algoritmi che permettono di derivare relazioni di causa ed effetto fra i fenomeni che i dati descrivono in modo quantitativo e qualitativo. L'insieme di tutti questi strumenti, che oggi utilizzano sempre più la tecnologia informatica costituisce un supporto sempre più efficace nei processi decisionali relativi a qualsiasi attività.

L'analisi dei dati nelle aziende

L'analisi dei dati come attività informatica a sé stante, rivolta al supporto della gestione tattica e strategica dell'azienda, comincia ad affermarsi, fra alterne vicende, durante la seconda metà degli anni novanta e continua a evolvere nel ventennio seguente traendo vantaggio dalla prodigiosa evoluzione tecnologica verificatasi soprattutto nei settori del software e dello sviluppo del Web. L'area applicativa principe dell'analisi dei dati è ovviamente costituita da vendite e marketing, ma non mancano sperimentazioni in altri settori egualmente importanti, quali la produzione (es. il controllo dei difetti di fabbricazione) e i relativi servizi di manutenzione, i servizi amministrativo-finanziari (es. controllo di gestione e investigazione dei fenomeni fraudolenti) e, infine perfino, la gestione delle risorse umane. Nella presente discussione ci si riferisce soprattutto alle applicazioni al marketing senza insistere troppo sulle intuibili possibilità di estensione ad altre aree applicative. Il settore industriale più attivo nella sperimentazione e nell'adozione è quello finanziario (per ragioni normative più abituato a curare disponibilità e qualità dei dati dei clienti) seguito da telecomunicazioni, settore farmaceutico e sanitario, retail, manifatturiero, e, solo più recentemente il settore pubblico. In prima fila sono, ovviamente, le organizzazioni di maggior dimensioni; ciò è dovuto soprattutto alla percezione comune, falsa secondo la maggior parte degli esperti, che l'utilità derivante da questa attività sia minore per la piccola e media azienda.

Il Marketing Relazionale

A differenza dell'approccio tradizionale, basato su vendite, transazioni e comunicazione di massa,

il marketing relazionale introduce il concetto di relazione a lungo termine con il cliente.

Questa rivoluzione affonda le sue radici nel pensiero di un grande innovatore, Philip Kotler,

il quale sosteneva che “Le imprese devono spostare la loro attenzione da obiettivi a breve termine,

incentrati sulle transazioni, a obiettivi rivolti alla costruzione di relazioni a lungo

termine con i clienti”. Successivamente le idee di Kotler sono state riprese ed elaborate,

fra gli altri da Don Pepper e Martha Rogers che hanno efficacemente pubblicizzato

il concetto di one-to-one marketing, ossia del marketing personalizzato. E' interessante notare che la

rivoluzione suddetta sia temporalmente parallela a quella verificatasi nell'informatica

con l'analisi dei dati. Infine occorre notare che secondo gli autori citati il

marketing relazionale è basato su tre capisaldi:

- Offrire maggior valore in termini di prodotti e servizi

- Fornire nuove basi per la fedeltà al marchio

- Utilizzare le nuove tecnologie

Il panorama odierno

Allo stato attuale dell'arte possiamo identificare tre filoni

fondamentali nell'analisi dei dati nelle aziende:

1. Business Intelligence tradizionale

2. Advanced Analytics

3. Social Media, Text Mining, Big Data, Data Science

1. Business Intelligence tradizionale

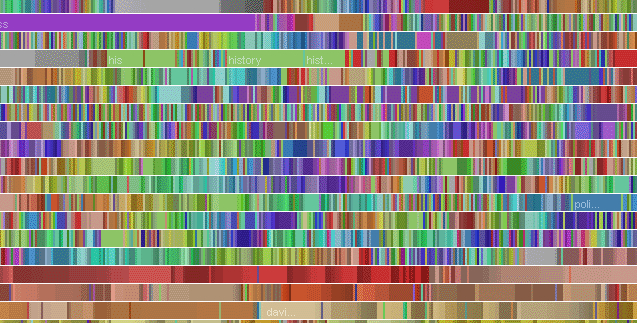

La Business Intelligence tradizionale è la metodologia che permette la produzione di report, che illustrano in forma tabellare e/o in forma grafica l'andamento di un determinato fenomeno, normalmente le vendite, in funzione di vari parametri quali, il tempo, la geografia, le strutture organizzative aziendali, ecc. Alla base della metodologia è una struttura dati (normalmente appoggiata a una sistema di base dati di tipo relazionale o RDBMS) costituita da una tabella centrale (tabella dei fatti) contenente i record delle singole transazioni di vendita. Nelle colonne della tabella sono presenti i puntatori a una serie di tabelle relative ai parametri sopra menzionati, detti anche dimensioni. La struttura è nota comunemente come schema a stella (star-schema) dove il corpo della stella è la tabella dei fatti, mentre le dimensioni costituiscono i bracci della stella. SQL, il linguaggio d'interrogazione delle basi dati relazionali, costituisce il motore per la costruzione delle tabelle-risultato da rappresentare anche in forma grafica e quindi per la produzione dei report. Inizialmente tutti i report, dai più semplici ai più complicati, venivano costruiti solo dagli specialisti d'informatica e quindi distribuiti ai vari utenti finali. Oggi, accanto a tale modalità, gli strumenti più evoluti permettono quella che viene denominata 'self-service BI' ossia la costruzione di report direttamente da parte dell'utente finale mediante l'uso di un'interfaccia grafica che lo scherma dalla scrittura esplicita della query SQL corrispondente al report costruito. La 'self-service BI' non è tuttavia l'unica evoluzione della reportistica. L'abbattimento dei silos aziendali dei dati, favorito dall'affermarsi delle tecniche di data warehouse, ha portato alla costruzione di report più complessi dei semplici report delle vendite, basati su un unico star-schema. Si possono così rappresentare dei fenomeni più complessi, come, per es. il comportamento della clientela, magari integrando nella data warehouse anche i risultati degli algoritmi che verranno descritti al punto 2. La disponibilità di software di reportistica sia proprietario, sia Open Source, è molto ampia, il che permette al dipartimento IT delle aziende di selezionare il pacchetto che soddisfa al meglio le necessità locali e più facilmente si inserisce nell'infrastruttura tecnologica.

2. Advanced Analytics

Gli strumenti di reportistica forniscono un ottimo strumento di navigazione dei dati delle vendite. Permettendoci di rappresentarli a nostra scelta a vari stadi di aggregazione e di dettaglio ci danno la possibilità di rispondere efficacemente alla domanda "COME SONO ANDATE LE VENDITE?'.

Il clustering comportamentale

E' però evidente che per il dipartimento di Marketing questo sia solo il punto

partenza. Per mettere in pratica gli insegnamenti del marketing relazionale

gli esperti cercano invece una risposta alle seguenti domande:

A) Possiamo identificare gruppi di clienti (segmenti) che hanno esigenze molto

simili, in modo da differenziare la nostra offerta in modo intelligente?

B) Quanto sono omogenei al loro interno tali gruppi e quanto diversi fra

loro?

La maniera tradizionale di rispondere a tali domande è basata sull'esperienza e

sull'intuito dell'esperto, corroborata da alcune misurazioni semplici, ma

assai importanti, quali la ben nota triade RFM (Recency - quanto recentemente

il cliente ha effettuato un acquisto, Frequency - quanto frequentemente si

verificano gli acquisti, Monetary Value - spesa totale del cliente). Si

stabiliscono degli intervalli per i singoli valori e utilizzando le query

SQL si estraggono dalla base dati aziendale i gruppi di clienti che soddisfano

tali condizioni stabilite a priori.

Le tecniche di Advanced Analytics permettono di superare le limitazioni insite

nel metodo tradizionale facendo uso di algoritmi che possono agire sull'insieme

completo di informazioni disponibili sul cliente (dati anagrafici, dati

qualitativi e quantitativi sugli acquisti effettuati, dati di richiesta di

servizi, dati di contatto, ecc.).

Tali algoritmi operano su una struttura dati diversa dallo star schema

abituale nell'analisi dei dati di vendita. Essi adoperano infatti

un'unica tabella, ospitata da un RDBMS, nella quale ciascuna riga

rappresenta un cliente, mentre le colonne contengono tutta l'informazione

relativa a quel cliente. La tabella si costruisce utilizzando i dati

contenuti nell'anagrafica dei clienti, i dati delle vendite, i dati di

contatto contenuti nei sistemi aziendali di CRM Operativo, ecc.

mediante un procedimento di ETL. L'output dell'algoritmo di clustering

è costituito invece da un'ulteriore colonna che specifica il numero del

segmento cui il cliente appartiene. Se in una colonna della tabella di

input è contenuto il numero di segmento assegnato con i metodo tradizionale

è anche possibile stabilire un paragone fra i due criteri e apprezzare

l'aumento di precisione fornito dal metodo basato sull'uso completo dei dati.

Essendo basato su tutte le informazioni che l'azienda possiede sui suoi

clienti questo tipo di clustering viene denominato spesso clustering

comportamentale o, anche, data driven clustering.

La natura e il significato dei vari segmenti costruiti si analizzano realizzando

una serie di report del tutto simili a quelli prodotti per l'analisi delle

vendite in modo da fornire una descrizione analitica ed esaustiva delle caratteristiche

comportamentali e dei bisogni tipici del gruppo di clienti contenuti in un dato segmento.

Il clustering comportamentale, soprattutto se applicato in maniera dinamica

su finestre temporali di osservazione di ampiezza appropriata alla natura

dell'attività dell'azienda, permette di conoscere in dettaglio la

clientela dell'azienda e quindi di sostenere le attività di pianificazione

strategica.

L'analisi predittiva

Il clustering comportamentale non è tuttavia l'unico strumento offerto dall'advanced analytics a supporto del marketing . L'analisi predittiva permette di costruire in maniera efficiente e razionale le liste di clienti cui indirizzare, sugli opportuni canali, offerte di nuovi prodotti o servizi potenzialmente di loro interesse. Si tratta dunque di un algoritmo di tipo tattico da applicare sistematicamente alla programmazione di campagne e promozioni. L'analisi predittiva adopera diversi algoritmi di machine learning, detti anche algoritmi di classificazione. Tali algoritmi analizzano il comportamento pregresso della clientela rispetto all'acquisto/non acquisto di un prodotto e servizio e assegnano a ciascuno dei clienti che attualmente non lo posseggono una probabilità che lo acquisiscano. Non resta quindi che scegliere il numero desiderato di destinatari dell'offerta/promozione fra i clienti con più alta probabilità di acquisizione. In parallelo a questa lista A sarà opportuno sempre effettuare la medesima promozione su una lista B ottenuta con le procedure tradizionali allo scopo di valutare quantitativamente e qualitativamente il miglioramento, anche economico, ottenuto mediante l'uso di maggiori informazioni sulla clientela. Oltre che per la fidelizzazione l'analisi predittiva viene spesso usata per il controllo dell'abbandono da parte dei clienti (churn analysis) e per l'acquisizione dei clienti (churn analysis) e per l'acquisizione dei clienti.

3. Social Media, Text Mining, Big Data, Data Science

Più che di un nuovo filone sarebbe forse più giusto parlare di un processo

che gradualmente sta generalizzando ed espandendo le attività descritte ai

punti 1 e 2, sfruttando soprattutto lo straordinario sviluppo del Web.

Fino a pochi anni fa le analisi di cui sopra sono state, nei casi più fortunati,

ristrette al perimetro dei dati strutturati della data warehouse aziendale,

o, più comunemente, a sottoinsiemi della stessa. Le dimensioni delle basi dati

raramente eccedevano pertanto le centinaia di Gigabytes.

L'analisi di dati consisteva dunque fondamentalmente nella ricerca estensiva

delle correlazioni fra le informazioni raccolte dall'azienda sui vari canali

interni e sulla loro estrapolazione statistica in chiave conoscitiva e previsionale,

come si è sopra spiegato per l'applicazione al marketing relazionale.

La disponibilità a costi accessibili di memorie sempre più grandi e di connessioni

di rete più veloci hanno negli ultimi anni portato alla sperimentazione, soprattutto

sul web, del calcolo distribuito e hanno reso possibile la memorizzazione e il

trattamento efficiente di moli di dati sempre più grandi.

Il fenomeno 'Big Data' non è tuttavia solo connesso al volume di informazione,

peraltro in continua ridefinizione. Si pensi che nel 2012 Gartner parlava di

poche decine di Terabyte, mentre oggi parla di alcuni Petabyte.

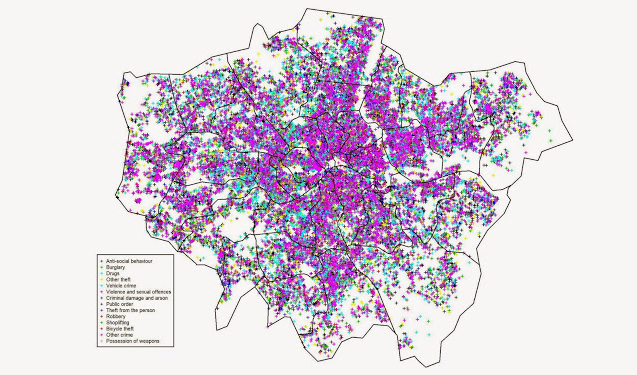

Accanto al volume occorre tenere infatti presente la varietà di dati oggi disponibili,

peraltro non solo all'interno dell'azienda, ma sull'impressionante numero di

siti accessibili liberamente o a pagamento:

- dati strutturati, prevalentemente su tecnologia relazionale o su file;

- dati testuali, prevalentemente in linguaggio naturale,

- dati provenienti dai disposivi collegati a internet (sensori, dispositivi mobili,

apparati vari semplici e complessi, ecc)

- dati multimediali (immagini digitali, registrazioni audio, video, ecc.)

I social media (Facebook, Twitter, LinkedIn, ecc.), infine, sono sorgenti di

dati di vario tipo, legati dalla particolare caratteristica di essere tutti

insieme generati dalle attività 'sociali' delle persone e quindi potenzialmente

utilizzabili per comprendere fenomeni di gruppo di indubbio interesse per

il mondo aziendale.

Per gestire la varietà e la velocità (la terza delle tre 'v' introdotte da

Gartner nella definizione di Big Data) sono stati introdotti e sono oggetto

di attiva sperimentazione, soprattutto nelle applicazioni sul web, nuovi

sistemi di gestione di basi di dati che superano alcune delle rigidità del

modello relazionale (NoSQL, NewSQL, InMemoryDB, GraphDB, ecc.).

Il compito dell'analisi dei 'Big Data' è sicuramente altrettanto arduo di quello

relativo alla loro organizzazione e manutenzione. Esso, infatti, non si può

ridurre alla mera trasposizione delle tecniche usate in passato proprio perchè

i 'Big Data' non provengono da ambiti omogenei come erano i vecchi dati aziendali,

ma si riferiscono a insiemi diversi che magari si sovrappongono solo parzialmente

fra loro e con lo stesso mondo aziendale.

Più che in passato è pertanto necessario definire con cura e precisione il

'problema di business' ed effettuare una ricerca esaustiva dell'informazione

utile disponibile, prima di scegliere gli strumenti informatici necessari allo

sviluppo della soluzione.

In questa ottica appare evidente che il termine Data Science non è una nuova

etichetta per rinominare attività già svolte in passato con altri nomi

(reportistica, data mining, advanced analytics, ecc.), ma un possibile nome

per nuove professionalità, non ancora del tutto definite, necessarie per gestire

la complessità che sta emergendo dal web e con la quale le aziende sono

costrette a confrontarsi. Tali professionalità dovranno padroneggiare non solo

gli strumenti tradizionali (pacchetti di reportistica, SQL, suite di Office

nelle sue versioni più evolute, pacchetti software di Data mining e analisi

statistica, ecc.) ma anche nuovi potenti strumenti di programmazione sul web

come R, Python e simili (vedere, per esempio il corso 'The Data Scientist

Toolset' su www.coursera.org).

Tuttavia quello che distinguerà un ottimo 'Data Scientist' da tutti gli altri

sarà non il potersi destreggiare fra linguaggi e pacchetti sempre più numerosi

quanto piuttosto il business acumen, ossia la comprensione profonda del particolare

problema che gli si pone davanti nel particolare contesto aziendale affrontato

(cfr. The one language a Data Scientist must master, blog di Matt Reaney).

Tale blog dovrebbe ispirare la ricerca degli specialisti di analisi dei dati a tutte

le aziende che vogliono intraprendere una reale integrazione dell'uso intelligente

dei dati nella loro attività quotidiana.

Ancora più che in passato è necessario che i progetti di utilizzazione dei dati

a scopo decisionale rappresentino iniziative di trasferimento tecnologico, oltre che

frutto di stretta collaborazione fra fornitori qualificati, informatica aziendale e

utenti finali. Il coinvolgimento di questi ultimi sin dalle prime fasi del progetto,

soprattutto nella definizione degli obiettivi di business e nella stesura delle

specifiche dei deliverable e delle relative modalità di utilizzazione, così come

nella responsabilità della gestione del gruppo di lavoro, risultano essenziali ai

fini del successo del progetto stesso.